乌镇,5 月 23 日 14 点 52 分。AlphaGo 1,柯洁 0。机器再次在围棋上打败人类。

柯洁是目前围棋等级分排名世界第一的选手。AlphaGo 是 Google 下属 Deepmind 开发的围棋人工智能,因去年 3 月 4:1 战胜围棋世界冠军李世乭成名。

比赛在上午 10 点半开始,下午 14 点 55 分裁判开始数子,比赛历时 4 小时 25分。

柯洁执黑先手,布局阶段使用了 AlphaGo 之前所用,而人类棋手几乎不会使用的开局“点三三”下法落子。柯洁途中上了一次厕所,和 AlphaGo 最终进行到官子阶段,在第 286 手之后开始数子。根据双方约定的中国式围棋规则,黑方柯洁九段先手贴三又四分之三子之后以 180 又四分之三子,输白方四分之一子,以围棋对决中最微小的差距落败。

接下来,柯洁还会在 5 月 25 日和 5 月 27 日与 AlphaGo 再下两盘,在 5 月 26 日,数名中国顶尖职业围棋选手还会组成团队和 AlphaGo 进行两盘团体和配对比赛。

在 AlphaGo 大败李世乭,并且化名 Master 在线打败柯洁之后,这次比赛的胜负没什么悬念,至少比去年李世乭赛前的期待要悲观得多。

“一年前我期待李世乭 3:2 或者 4:1 战胜 AlphaGo,我当时没预料它那么强大。今年的结果毫无疑问,AlphaGO 三场全胜。”阿尔伯塔大学教授乔纳森·谢弗(Jonathan Schaeffer)赛前对《好奇心日报》表示。谢弗教授是人工智能专家,曾带队制作跳棋和国际象棋程序。

博彩业的预测则是 AlphaGo 胜率 95.24%、柯洁 12.5%。AlphaGo 获胜赔率 1.05、柯洁获胜赔率 8。也就是说买 10 元柯洁获胜,将能获得 80 元;10 元买 AlphaGo 胜,就只能拿回 10.5 元。

但这次令人意外的地方是,AlphaGo 背后的计算能力只有此前对战李世乭那会儿的 1/10。

比赛之后的新闻发布会上,哈撒比斯在谈到 AlphaGo 的技术细节时解释说,去年战胜李世乭时,AlphaGo 的程序需要依靠全世界 Google 很多机房提供计算能力。

而今天的 AlphaGo 的算力需求更小,它不再是分布式运算,整个程序仅运行在一个单一的云服务器里。今天 AlphaGo 调用的算力只有对弈李世乭那会儿的 1/10。

换句话说,同样是战胜人类顶尖棋手,AlphaGo 的程序性能提升了至少 10 倍。

比赛为期五天,“低调”莫名

除了柯洁和 AlphaGo 的三番棋对局,5 月 26 号还会进行两场团体赛,分别是古力和 AlphaGo 配对,应战连笑和 AlphaGo 的组合;另外一场是五位中国围棋冠军共同对战 AlphaGo。

比赛在乌镇西栅景区的互联网国际会展中心举行,安保严密。门口停着一辆浙江警方的 PTU 巡逻车、进门社有安检、负责安保的武警和公安分布在会展中心各处。

有 120 多家中文媒体、十几家国外媒体在现场报道。媒体和工作人员,包括 Google 中国员工,都在比赛前半个月将个人信息上传到政府网站,进行备案和审核。

一年前李世乭对阵 AlphaGo 时,比赛安排在首尔四季酒店,现场簇拥着媒体。

在赛前的开幕式上,数位中国政府官员和 Google(Alphabet)董事长埃里克·施密特、Google 大中华区总裁石博盟、DeepMind 首席执行官丹密斯·哈萨比斯 (Demis Hassabis)登台致辞。

“我很荣幸再次回到中国。各位眼前看到的,是一个非常棒的改变世界的机会。Alphabet 带来的是在人工智能领域的新尝试。”施密特说。

据称是因为有关部门的要求,整场比赛在中国境内没有视频直播,曾在 4 月放出预告的 CCTV5 体育台直播被换成篮球直播。

你能在 YouTube 上看到现场直播,有中英文语言版本。多家网站曾转播 YouTube 视频,但比赛中途全部撤下。

围棋是人脑在棋类上的最后防线

1996 年 2 月 10 日,IBM 研发的国际象棋超级计算机“深蓝”尝试挑战当时的国际象棋世界冠军,俄罗斯棋手加里·基莫维奇·卡斯帕罗夫,这轮六局比赛卡斯帕罗夫保住了胜利,深蓝总比分 2 比 4 落败。

1997 年 5 月 3 日,国际象棋人工智能“深蓝”的升级版“更深的蓝”挑战国际象棋世界冠军加里·基莫维奇·卡斯帕罗夫,以两局胜利和三盘和棋,总比分 3.5 - 2.5 获胜。

比赛前,美国《新闻周刊》在封面上印出“人脑最后防线”的标题。

但其实围棋才是人脑在公平游戏里的最后防线。

围棋棋盘一共有 361 个落子点,平均分配的话,一方棋子占据的位置加上活棋围住的落子点只要超过 180.5 个就会胜利。

规则虽然简单,但是围棋每一步的可能性都是天文数字,靠计算机穷举原理上就是不可能的。

而在大众看来,人工智能的思考能力不如人类,所以即使在卡斯帕罗夫败给深蓝之后,围棋也被认为是计算机没办法“学会”的一门技艺。

人工智能和人类下棋的历史

1996年2月

IBM 超级计算机“深蓝”挑战国际象棋世界冠军卡斯帕罗夫,但 2:4 落败。

1997年5月

升级的深蓝再战卡斯帕罗夫,3.5:2.5 战胜卡斯帕罗夫。

2012 年

Zen 围棋 AI 在让 5 子和让 4 子的情况下两次击败日籍九段棋手武宫正树,AI 刚刚摸到了人类顶尖棋手的边缘。

2015年10月

AlphaGo 5:0 战胜职业棋手欧洲冠军樊麾二段,这是 AI 第一次战胜职业围棋棋手。

2016年3月

AlphaGo 4:1 战胜职业棋手李世乭九段,围棋等级分一度超过所有人类棋手位列第一。

2017年5月

AlphaGo 战胜目前排名世界第一的柯洁九段。

之后十多年里,围棋人工智能的棋艺相距人类围棋大师甚远。直到 AlphaGo。

计算性能的进步打败了象棋大师,计算方法的进步打败了围棋大师

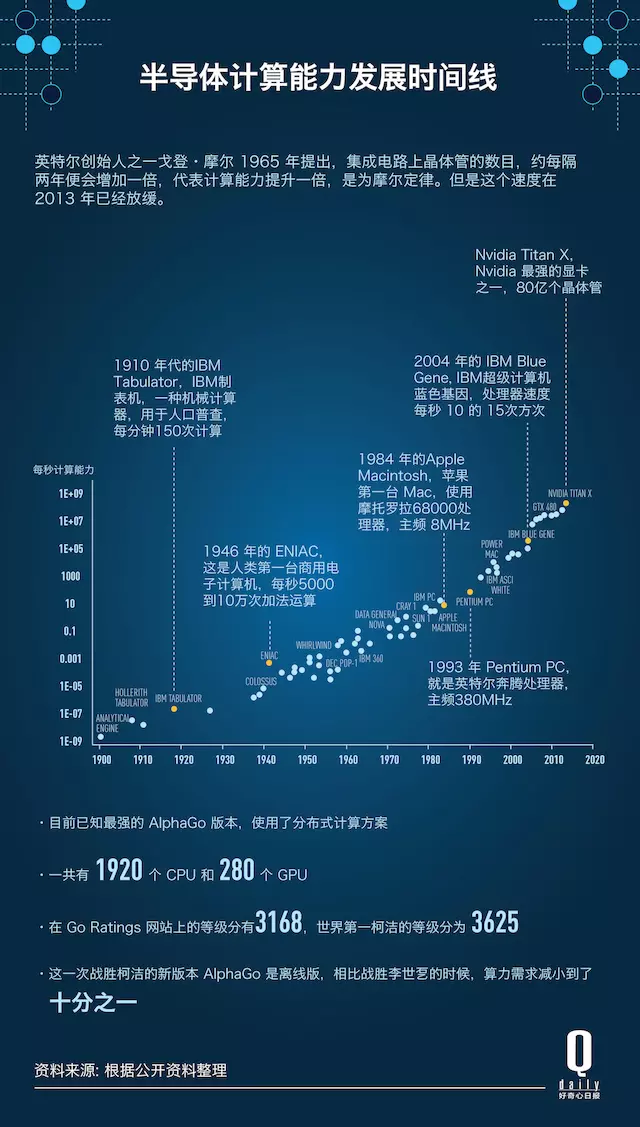

人工智能依托的电子计算机,从诞生之日起,就是比人类强大的多的计算工具。

人类的第一台商用电子计算机,1946 年诞生于美国宾夕法尼亚大学的 ENIAC 和现在的电脑相比非常笨重和迟钝,但即使是这台占地几间大教室的老古董,每秒也可以进行 5000 到 10 万次加法运算。

在这之后,电子计算机在半导体工业的发展下突飞猛进。1965 年,英特尔的创始人之一戈登·摩尔发表了著名的“摩尔定律“,他提出,大规模集成电路上晶体管的数量,会随着材料和工艺的进步逐渐增加,大约每隔两年便会增加一倍,同时计算能力也提升一倍。

回过头来看,从 1900 年到 2015 年这 100 多年,人类计算机机器的性能确实沿着“摩尔定律”发展。从 1900 年代用于人口普查的机械制表器每分钟 150 次计算能力开始,到 2016 年 Nvidia 推出的 GeForce Titan X 显卡,在火柴盒大小的芯片上已经集中了 80 亿个晶体管。

关于战胜卡斯帕罗夫的“深蓝”有一种误解,认为超级计算机深蓝是靠单纯的“穷举”,通过计算所有的可能性来实现胜利。实际上,深蓝的算力约为每秒 2 亿步棋,想要穷尽国际象棋十的四十五次方这个级别的可能性需要十的二十九次方年的时间,这显然不可能。

最终在公平游戏中战胜人类的 AlphaGo 同样不依靠穷举,现在看来,它也不是非常依赖电子计算机的发展。

2013 年开始,国际半导体发展路线图组织的数据显示,摩尔定律已经逐渐失效,每两年增加一倍的计算里已经逐渐扩大到了三年,随着材料和工艺瓶颈,摩尔定律最终可能完全失效。

今天英特尔的处理器已经不能维持摩尔定律,每年的产品升级更多是在降低制造成本。

而 Nvidia 的性能提升则依赖于显卡本身,因为显卡对功率和散热的需求不是那么苛刻,顶级显卡都是板砖那么大的一块,所以核心面积可以比 CPU 更大,晶体管更多,运算能力更强。

相比于过去 50 年的飞速发展,大规模集成电路最终可能进入原地踏步的境地。

AlphaGo 打败人类,靠的是深度学习。上一个版本的 AlphaGo,每秒钟可以计算几百万步棋,通过大量学习人类棋局,用这些经验自我对弈产生新的经验,用这些新经验来下棋。

而后 AlphaGo 再利用蒙特卡罗树搜索产生下一步对应的下法,最后配合“乱下”产生的对局面的评估,最终取得胜利。更详细的解释,可以看这篇文章。

这次战胜柯洁的 AlphaGo 一定用了新的算法和逻辑,才能在十分之一的算力里完成战胜人类顶尖棋手的围棋水平。

“围棋,我还是喜欢跟人下。”柯洁在比赛结束后的发布会这么说道。

来源:好奇心日报

如若转载,请注明出处:https://www.zhangzs.com/221809.html

微信扫一扫

微信扫一扫